全球AI治理迈入新阶段:”上海共识”划定行为红线,呼吁构建主动安全体系

- AI

- 2025-07-29

- 283热度

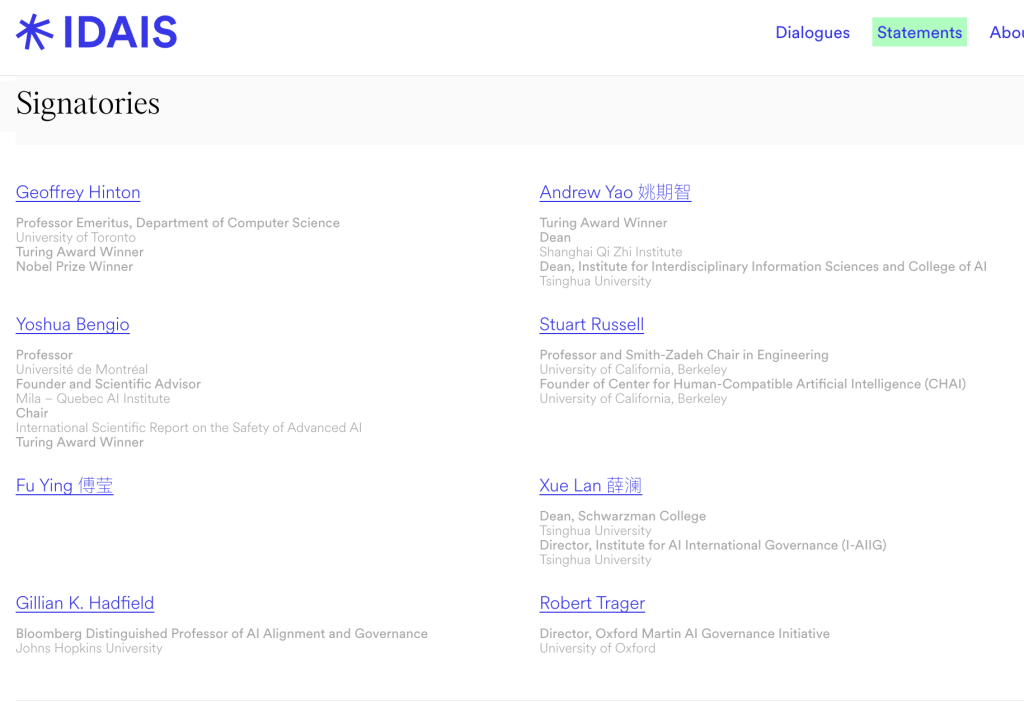

“国际社会应确立具体、可操作、受全球认可的红线,确保人工智能系统在任何情况下均不得逾越。”7月25日, 由杰弗里·辛顿(Geoffrey Hinton)、姚期智、本吉奥(Yoshua Bengio)、斯图尔特·罗素(Stuart Russell)等20余位行业专家、学者共同签署的AI安全国际对话上海共识(以下简称“上海共识”)正式对外公开。

2024年3月,辛顿、姚期智、罗素、本吉奥等专家曾共同签署“北京共识”,主张限制AI系统复制、欺骗、武器开发等行为,尤其呼吁行业为AI的研发和应用戴上“紧箍咒”,避免相关技术被滥用,推动全球治理机构构建。姚期智透露,18个月前举办第一次安全共识会议时,AGI强大的破坏力就已经显现,人类甚至难以阐明其失控机制,不过随着相关会议的推进,已经看到若干有关基于“设计的安全”(Safe by design)提案,这意味着实际上人类可以找到确保AI安全的可行路径。

2024年3月,辛顿、姚期智、罗素、本吉奥等专家曾共同签署“北京共识”,主张限制AI系统复制、欺骗、武器开发等行为,尤其呼吁行业为AI的研发和应用戴上“紧箍咒”,避免相关技术被滥用,推动全球治理机构构建。姚期智透露,18个月前举办第一次安全共识会议时,AGI强大的破坏力就已经显现,人类甚至难以阐明其失控机制,不过随着相关会议的推进,已经看到若干有关基于“设计的安全”(Safe by design)提案,这意味着实际上人类可以找到确保AI安全的可行路径。

此次“上海共识”指出,当前人类正处于一个关键转折点:人工智能系统正迅速接近并可能超越人类智能水平。这些未来的系统可能在操作者毫不知情的情况下,执行并非操作者所期望或预测的行动。这可能导致失控,即一个或多个通用人工智能系统脱离任何人的控制,从而带来灾难性甚至是生存层面的风险。当前,对于能够在更高级的通用人工智能超越人类智能水平后,仍可靠地确保其对齐,并保持人类的有效控制尚无可行方法。

多位与会专家在参与讨论时也提及,当前构建真正有约束力且值得信赖的国际AI安全框架难度高、风险大。

上海人工智能实验室主任周伯文教授指出,当前“Make AI Safe(使AI安全)”面临困境,其采用事后价值对齐、修补的被动回应模式,存在防御成本高、攻击成本低的问题。与之相反,“Make Safe AI(构建安全的AI)”则是主动的、在线共同演进,防御成本低且具备各级风险的应变能力。

周伯文认为,训练模型变友善与变聪明或许起初是不同技术路径,但当性能发展到一定程度,二者很难分开处理,就如牛顿定律在物体逼近光速时失效一样。所以,下一代模型的“善”与“智”会相互影响、共同进化。

约翰·霍普金斯大学人工智能对齐与治理方向杰出教授吉莉恩·哈德菲尔在接受采访时强调,推动“Make AI Safe”需设立AI“红线”,开展跨国界合作并建立安全合规系统。

在此背景下,“上海共识”提出应对策略并呼吁三项关键行动。对于前沿人工智能开发者,“上海共识”要求其在模型部署前进行全面内部检查与第三方评估,提交高可信安全案例,开展模拟攻防与红队测试。若模型达到关键能力阈值,如具备帮助非法分子制造生化武器的能力,开发者要向政府(必要时向公众)说明潜在风险。

同时,“上海共识”呼吁国际社会合作划出人工智能开发的“红线”,聚焦系统行为表现,综合考虑其执行特定行为的能力与倾向性。为落实红线,各国应建立具备技术能力、国际包容性的协调机构,汇聚各国人工智能安全主管机构,共享风险信息,推动评估规程与验证方法标准化。

“上海共识”还指出,短期需建立可扩展监管机制,应对AI欺骗问题、提升抵御“越狱”攻击能力、强化信息安保投入;长期则要构建“基于设计的安全”架构,变被动应对为主动预防,为人工智能安全发展指明方向。